Wenn Kreditinstitute über den Einsatz von Künstlicher Intelligenz nachdenken, bereitet ihnen der Gedanke an Regulierung oftmals Kopfschmerzen. Denn: Die Entscheidungen der Künstlichen Intelligenz sind in der Regel nicht nachvollziehbar. Doch es gibt eine Lösung dafür.

Explainable AI erschließt Banken und Sparkassen neue Möglichkeiten.

Neuronale Netze, Entscheidungsbäume, Random Forests, Regressionen und viele mehr – die Methoden im Einsatz von Künstlicher Intelligenz sind vielfältig. In der Regel können durch die Auswahl des richtigen Trainings-Algorithmus insbesondere bei Finanzdienstleistern vielversprechende Ergebnisse erzielt werden. Je nach Komplexität und Struktur des ausgewählten Trainings-Algorithmus sind die errechneten Ergebnisse oder Prognosen jedoch nur sehr schwer nachzuvollziehen.

Im Rahmen der sogenannten dritten KI-Welle wird die Plausibilisierung von KI-Ergebnissen namentlich als Explainable AI erforscht. Dabei liegt der Fokus insbesondere in der nachträglichen Nachvollziehung lokaler Entscheidungsbestandteile eines komplexen Modells und nicht in der Entwicklung eines transparenten Modells, welches durch seine Struktur bereits preisgeben kann, wie bestimmte Vorhersagen oder Entscheidungen errechnet werden. Erste Erkenntnisse, beispielsweise durch den LIME-Algorithmus, werden bereits heute verwendet, um Schwachstellen in Modellen und ihren zugrundeliegenden Daten zu ermitteln, Modelle nachträglich zu verbessern und kritische Entscheidungen zu überprüfen.

Dieser neue Evolutionsschritt der Künstlichen Intelligenz scheint die Finanzwelt bislang nur wenig zu tangieren, obwohl dadurch ein zentrales Problem gelöst wird: das Erfüllen regulatorischer Anforderungen. Zu groß sind aktuell noch die Bedenken hinsichtlich einer KI-Einführung, zu gering die Risikobereitschaft und das Know-How in den meisten Instituten. Welchen praktischen Platz hat die nachträgliche Plausibilisierung von Modell-Ergebnissen tatsächlich in der Finanzwelt? – Ein kurzer Überblick.

Nachvollziehbarkeit der Modelle ist durch die BaFin explizit gefordert

Für 42 Prozent der Banken stellen regulatorische Hürden im laufenden Geschäft eine große und kostenintensive Herausforderung dar. Dies ergab eine Capgemini-Studie im November 2020, welche unter anderem auf die strengen Vorgaben der BaFin für Geldinstitute hinweist. Finanzdienstleister sind somit weiterhin stark von den Vorgaben des Regulators abhängig – auch bei der Einführung von neuen Produkten und Geschäftsmodellen.

Dies gilt besonders für technisch unterstützte Prozesse und Entscheidungen. Die BaFin stellte diesbezüglich bereits im Juni 2018 in einer Studie im Hinblick auf den Einsatz von Künstlicher Intelligenz fest, dass insbesondere bei kritischen Anwendungen die nachträgliche Nachvollziehbarkeit der getroffenen Entscheidungen gewährleistet werden muss. Dies kann jedoch zunächst lediglich bei einigen wenigen Trainings-Algorithmen garantiert werden, welche eine geringe Komplexität besitzen und somit einen transparenten Trainingsablauf unterstützen – beispielsweise Entscheidungsbäume. Ein tatsächlicher Mehrwert wird jedoch primär durch die Verwendung tiefgehender Trainings-Methoden geschaffen, welche als solche nach dem sogenannten Black-Box-Prinzip zunächst keinen Einblick in den Entscheidungsprozess geben können.

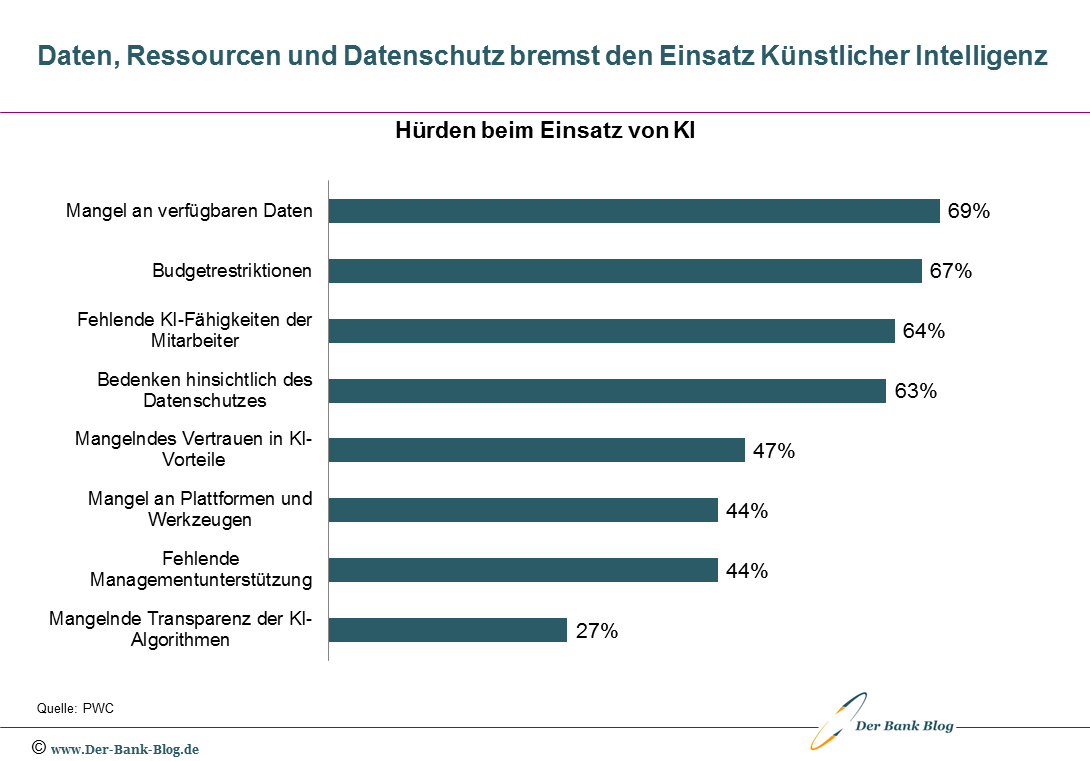

Fehlende Daten und Ressourcen sowie Bedenken beim Datenschutz sind die wichtigsten Hürden für den Einsatz Künstlicher Intelligenz im Finanzsektor.

Bei einer 2020 durch das Beratungshaus PwC durchgeführten Studie zur Künstlicher Intelligenz im Finanzsektor mit 151 Entscheidern der Finanzbranche gaben 27 Prozent der Befragten an, eben dieses Black-Box-Problem als Hürde bei der Einführung und Pflege von KI-Systemen wahrzunehmen.

Das zeigt: Um gewinnbringende Modelle in Banken einsetzen zu können, muss die nachträgliche Erklärbarkeit von Entscheidungen durch die KI gewährleistet werden. Zwar nicht mittels globaler Grundsätze, welche die Funktionsweise des gesamten Modells erklären, dafür aber durch lokale Ansätze, welche eine konkrete Entscheidung nachträglich erklären können. Explainable AI schlägt somit die Brücke zwischen der Notwendigkeit komplexer Trainings-Algorithmen und der regulatorischen Anforderung, Funktionsweisen für einzelne Entscheidungen belegen zu können.

Notwendige Auskünfte gegenüber dem Kunden sind oft nicht möglich

Weitere 63 Prozent der Unternehmenslenker tragen laut der PwC-Studie Bedenken hinsichtlich des Datenschutzes bei der Verwendung von KI-Algorithmen, denn beim Modell-Training dürfen nur bestimmte Merkmale zur Gewinnung von Erkenntnissen verwendet werden. Neben der rechtlichen Limitierung der zu verwendenden Datenbasis müssen Finanzdienstleister insbesondere im direkten Kontakt mit dem Kunden auf eine weitere Richtlinie achtgeben – die DSGVO. Laut dieser hat jeder Kunde ein Recht darauf, Auskunft über die Hintergründe einer Entscheidung, vor allem aber die zweckgemäße Verwendung seiner Daten, zu bekommen.

Bei vielen Trainings-Algorithmen ist eine Aussage über die Art der verwendeten Daten und wofür sie genau verwendet werden wegen ihrer Komplexität ohne Weiteres nicht möglich. Aufgrund der konkreten Einzelabfrage für einen bestimmten Kunden kann Explainable AI jedoch dabei unterstützen, die für eine konkrete Entscheidung verwendeten Daten zu identifizieren und sogar deren Gewichtung im Entscheidungsprozess darzustellen. Nach der Betrachtung einzelner Parameter können die daraus gewonnen Erkenntnisse im Zweifel dafür verwendet werden, das Modell weiter zu verbessern. In diesem Schritt muss ein besonderes Augenmerk darauf gelegt werden, dass es sich hierbei um lokale Einzelerkenntnisse handelt, welche nicht zwingend in Korrelation mit anderen Kundendaten oder der Modell-Logik als Ganzes stehen.

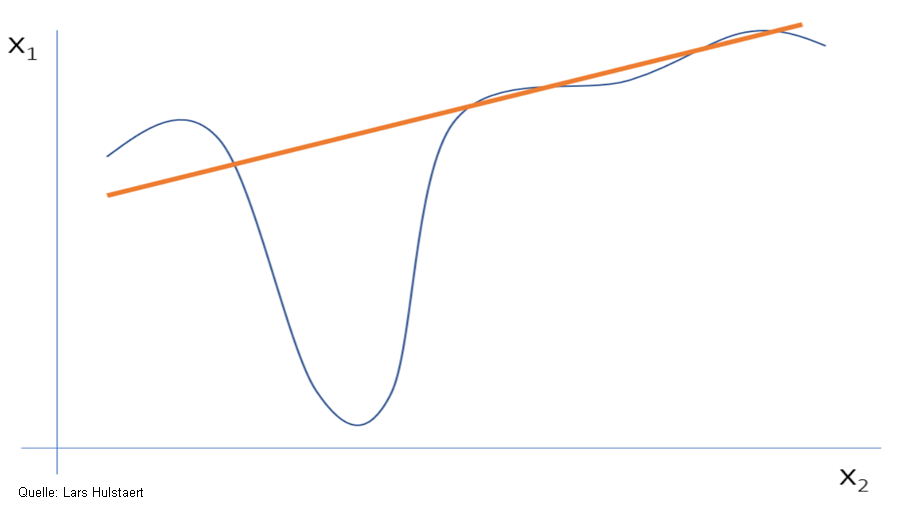

Explainable AI arbeitet mit vereinfachten Modellen für einen Punkt (orange). Dadurch werden grundsätzlich globale Ausreißer vernachlässigt, die in komplexen Modellen berücksichtigt werden (blau).

Denn Explainable AI ermittelt lokale Ergebniswege nachträglich durch das Approximieren einzelner Werte mit Hilfe von weniger komplexen – also transparente – Algorithmen. Ein Entscheidungsfall eines Neuronales Netzes kann so beispielsweise durch eine Lineare Regression an einem bestimmten Punkt hergeleitet werden. Die mit dieser Methode hergeleiteten Werte sind dann jedoch nur für einen speziellen Fall zutreffend. Ausreißer, welche nicht von einem vereinfachten Algorithmus berücksichtigt werden, können im Zweifel bei nur leicht anderen Parametern ein konträres Verhalten aufweisen.

Lösungsansätze durch Explainable AI

Somit gilt: Explainable AI kann bei komplexen KI-Modellen rückblickend Einflussfaktoren ermitteln und gewichten, welche eine Auswirkung auf eine KI-gestützte Entscheidung haben. Durch den Einsatz dieser Technologie werden demnach Geldinstitute dazu befähig, auch komplexe Prozesse KI-gestützt zu gestalten, Kostenreduktionspotenziale zu erschließen und gleichzeitig den regulatorischen Voraussetzungen des Gesetzgebers gerecht zu werden. Während des Einsatzes von Explainable AI muss jedoch darauf Acht gegeben werden, eine Einschätzung als Einzelaussage zu verstehen, die stark im Zusammenhang mit den durch das Modell verwendeten Daten steht.